自己安裝 docker ollama + GLM-4.7-flash

openclaw 連接報錯:does not support tools

目前 Ollama 中的 glm4 模型並不支援標準的 OpenAI Tool Calling 協議。模型相容性 (Capabilities) 問題。

本來要放棄了,但是,看到這篇:

https://www.facebook.com/share/p/18GntSv86A/

重新燃起希望。

google 一下,找到這個東西: ollama launch.

到:

https://docs.ollama.com/

下載,

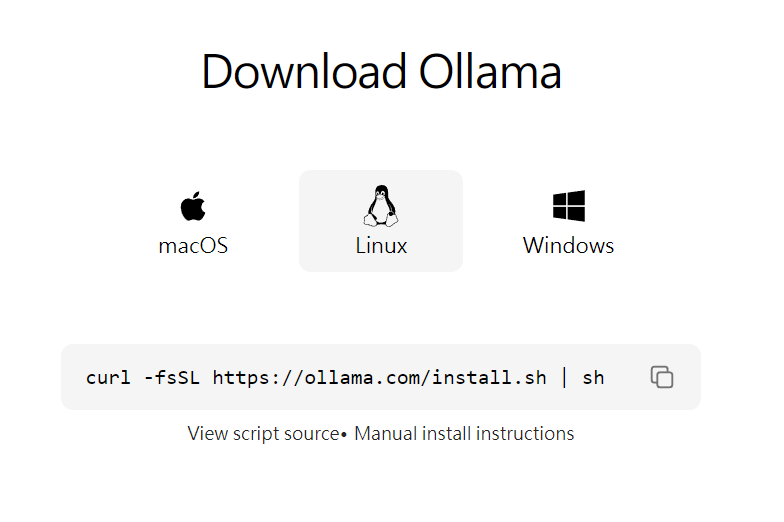

我是 linux:

執行:

curl -fsSL https://ollama.com/install.sh | sh

開始安裝:

bob@srv-73:/$ curl -fsSL https://ollama.com/install.sh | sh

>>> Installing ollama to /usr/local

[sudo] password for bob:

>>> Downloading ollama-linux-amd64.tar.zst

######################################################################## 100.0%

>>> Creating ollama user…

>>> Adding ollama user to render group…

>>> Adding ollama user to video group…

>>> Adding current user to ollama group…

>>> Creating ollama systemd service…

>>> Enabling and starting ollama service…

Created symlink /etc/systemd/system/default.target.wants/ollama.service → /etc/systemd/system/ollama.service.

>>> NVIDIA GPU installed.

ok. 再執行:

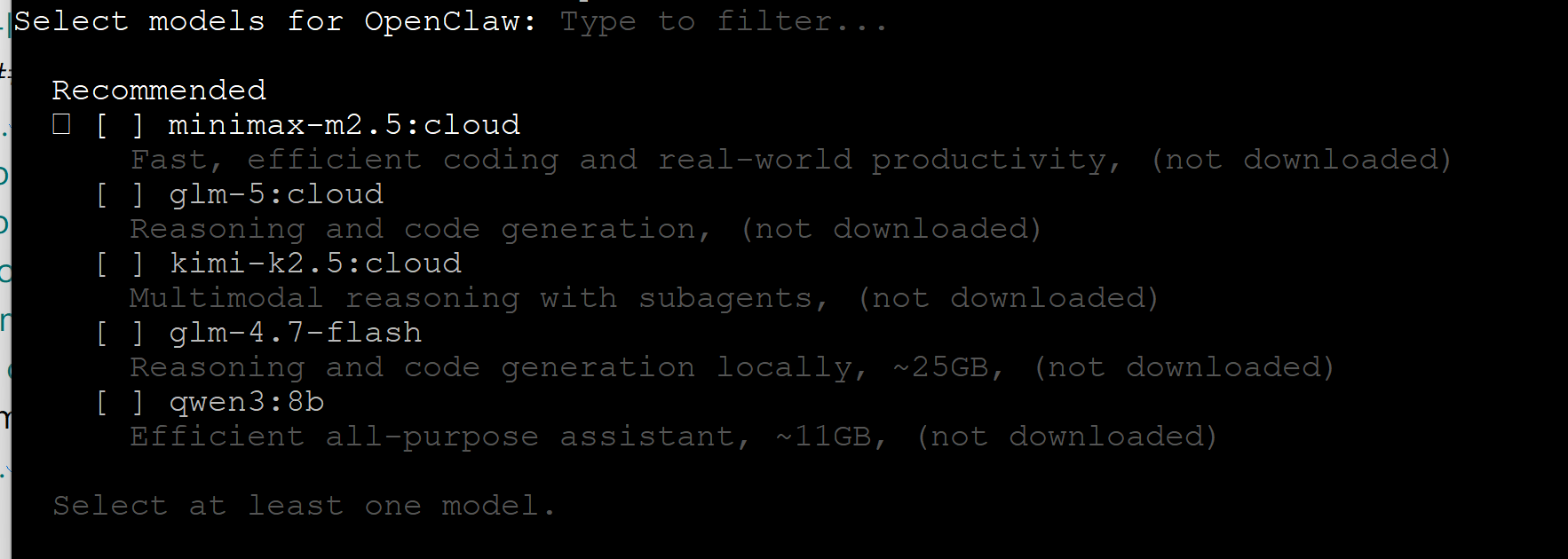

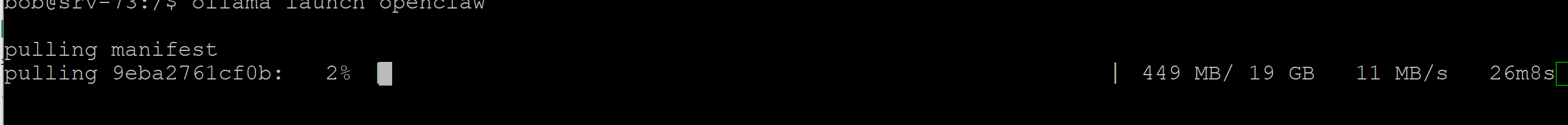

ollama launch openclaw –model glm-4.7-flash

或執行

ollama launch openclaw

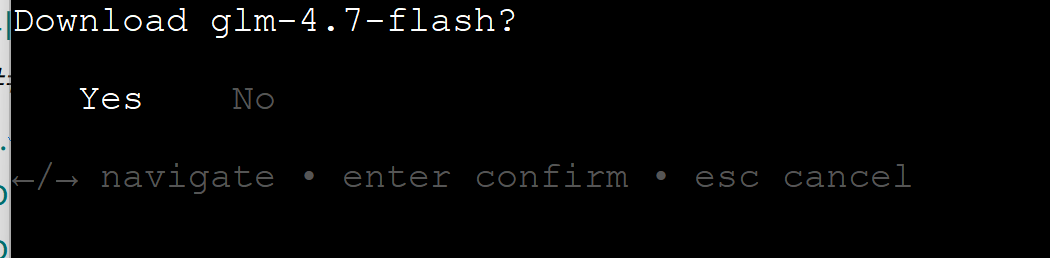

選 GLM 4.7

下載中

…… 然後才想到,這台機器只是用來跑 LLM Models, 龍蝦不在這。

下載完,因為沒裝 openclaw, 問我要不要裝,No. 結束。

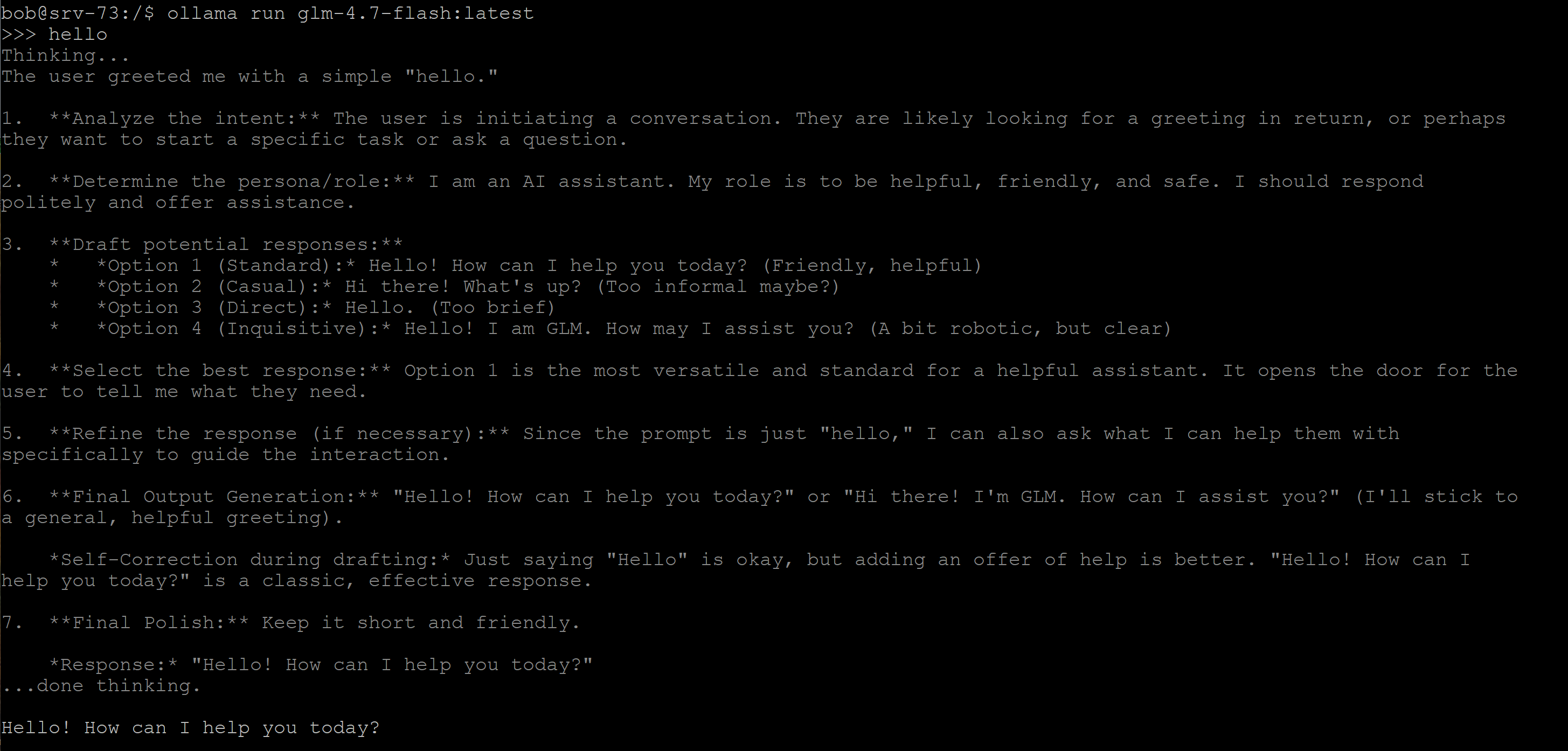

跑一下:

ollama run glm-4.7-flash:latest

跑起來了

測試一下:

curl http://localhost:11434/api/generate -d ‘{

“model”: “glm-4.7-flash:latest”,

“prompt”: “Hello!”

}’

本機 ok

curl http://192.168.8.73:11434/api/generate -d ‘{

“model”: “glm-4.7-flash:latest”,

“prompt”: “Hello!”

}’

用 IP 測失敗。

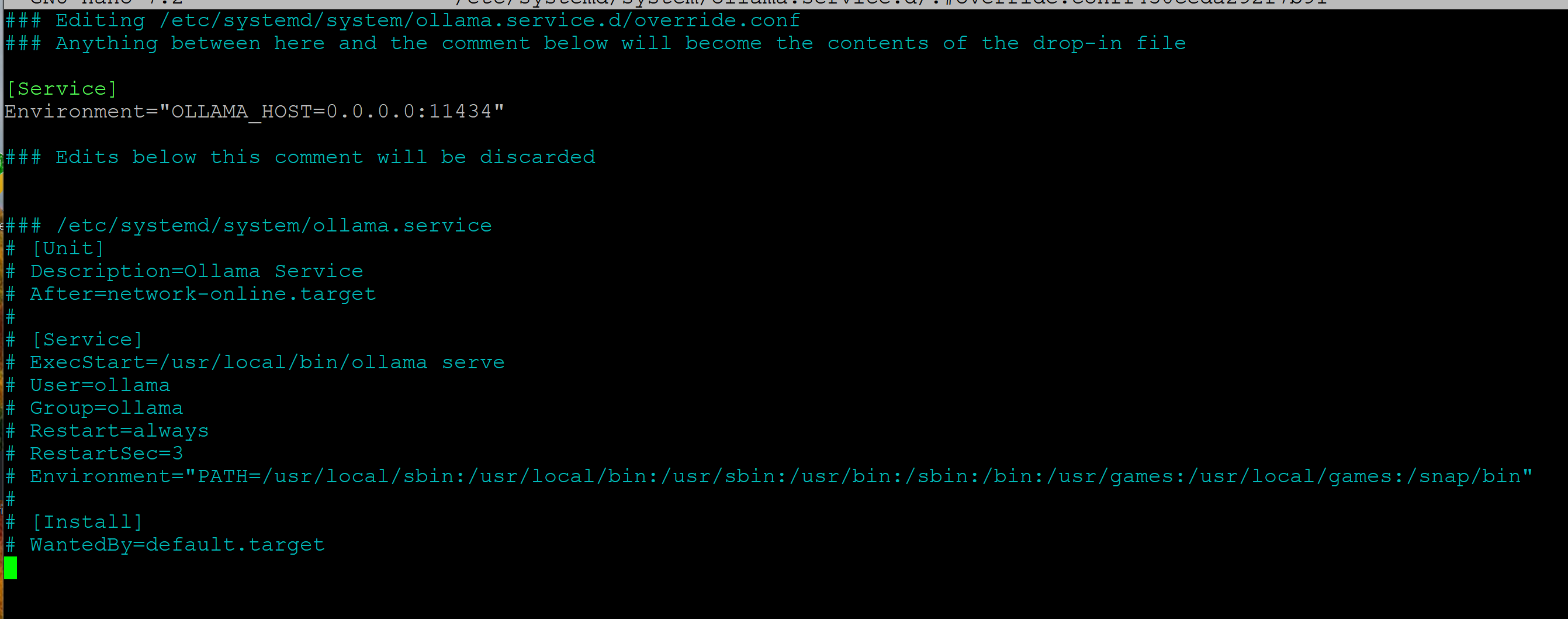

問 Perplexity,ollama 預設不對外開放。要讓 ollama 可以接收外來連線:

sudo systemctl edit ollama.service

輸入:(輸入在上端空白處)

[Service]

Environment=”OLLAMA_HOST=0.0.0.0:11434″

儲存

重啟

sudo systemctl daemon-reload

sudo systemctl restart ollama

sudo ss -tlnp | grep 11434

顯示:

LISTEN 0 4096 0.0.0.0:11434 0.0.0.0:* users:((“ollama”,pid=449027,fd=3))

ok. 0.0.0.0:11434 ,可以接收連線要求了。

openclaw :

openclaw config

model

選 : Customer Provider

url : https://yourdoamin/v1

token : 隨便輸入, ollama 不用

model name : glm-4.7-flash:latest

openclaw gateway restart

# edit :

有個地方要改:

openclaw.json

glm-4.7-flsh :

“contextWindow”: 131072, <—— 要改大一點,因為我是 5060 16 G x2 ,所以就放大一點。

“maxTokens”: 8192 <—— 原來是 4096,順手改大一點。

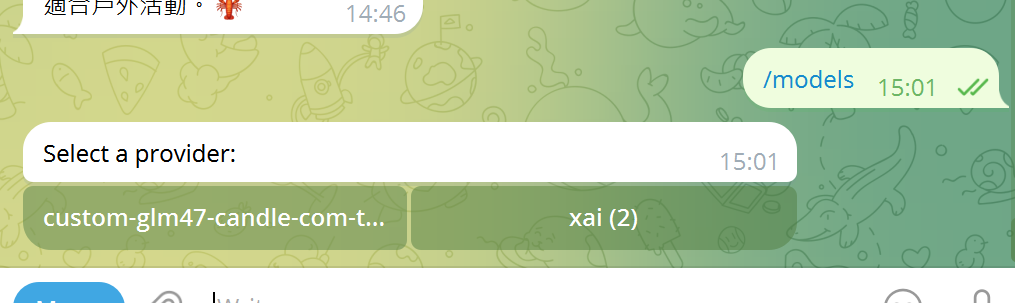

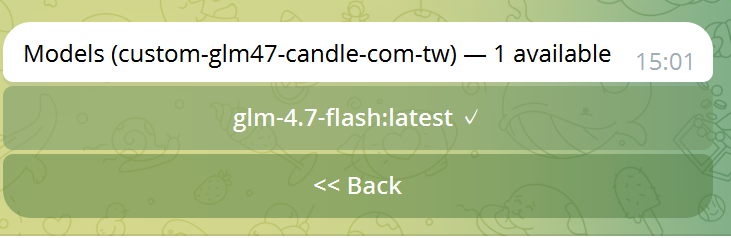

telegram :

/modles

選 glm-4.7-flash 給他點下去。

完工。

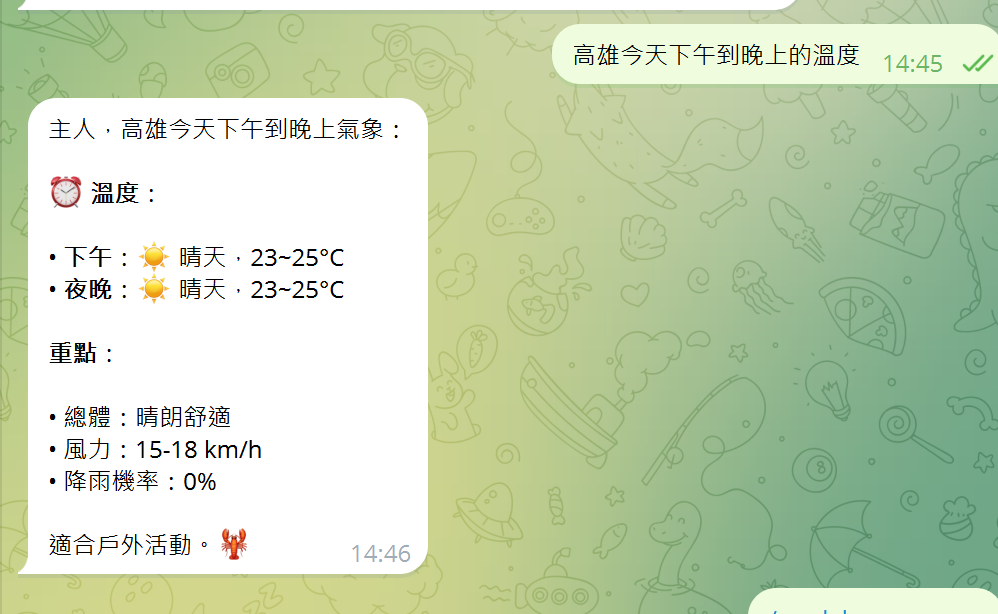

比較一下:

GLM-4.7-flash :

Grok-4.1-flash :

看來要花錢還是比較乖巧機靈點。